Comment résoudre la tension entre potentiel de l’IA et craintes associées ?

L’objectif de cet article est de présenter la démarche participative sur le thème « data science responsable et de confiance » que nous avons initiée à l’été 2019 et que nous animons depuis. Je vais suivre pour cela le fil de la présentation que j’en ai faite au meetup “Big data & ML” le 29 septembre 2020. J’espère que ce format blog permettra à un maximum de monde de découvrir cette initiative, peut-être d’y réagir, voire de venir y contribuer. Tous les retours sont les bienvenus, ils viennent alimenter la réflexion et les travaux et nous en avons besoin !

Une tension grandit entre l’intérêt pour les techniques d’IA et les craintes qu’elles suscitent

L’intérêt pour “l’IA”, la science des données en général, est en pleine croissance depuis plusieurs années. Les cours en ligne, les masters sur le sujet se multiplient, ainsi que les outils, les publications, les cabinets spécialisés, les produits et services : la liste est infinie. À la date d’écriture de cet article, cette déferlante ne s’est pas encore tout à fait matérialisée dans les systèmes informatiques en production. Mais elle s’en rapproche, et l’accélération est notable. Nul besoin de vous convaincre si vous êtes arrivés jusqu’à cet article… !

Mais là où l’IA semble prometteuse et génère un intérêt grandissant pour de nombreux cas d’usage, elle suscite également des craintes, et chaque mois qui passe voit son lot de lancements ratés et de scandales de plus ou moins grande ampleur. La liste des “Awful AI” maintenue par David Dao en est remplie ; celui qui m’a frappé au cours de l’année écoulé est celui de l’Apple Card comme l’illustrent les tweets ci-dessous, ce qui montrent que même les géants technologiques les plus avancés ne sont pas à l’abri de ces risques :

On observe donc une tension qui grandit, entre d’un côté le potentiel et l’intérêt des techniques d’IA, et de l’autre la difficulté à faire confiance à ces techniques ou à leurs mises en oeuvres (que ce soit par des acteurs privés comme Apple dans l’exemple précédent, Tesla dans cet exemple étonnant, ou par des acteurs publics comme les Etats, cf. COMPAS sur les libérations conditionnelles aux USA, les controverses chaque année sur Parcoursup en France, les allocations chômage aux Pays-Bas, et bien d’autres). Et dans ce contexte, il devient de plus en plus délicat pour une organisation de mettre en oeuvre des approches de data science dans ses produits et services et de l’assumer publiquement.

Pour résoudre cette tension il faut faire émerger un cadre

Evidemment cette tension ne date pas d’hier, certains risques sont bien réels, et il me semble que règne une forme de consensus général sur le fait qu’il faille faire émerger des cadres structurants et rassurants. Il suffit de taper “IA et éthique” ou “IA responsable” dans un moteur de recherche pour voir le foisonnement d’initiatives dans ce domaine. Nous avions par exemple recensé fin 2019 déjà 3 méta-études sur les principes éthiques et responsables pour l’IA :

The global landscape of AI ethics guidelines, A. Jobin, M. Ienca, E. Vayena, Juin 2019

A Unified Framework of Five Principles for AI in Society, L. Floridi, J. Cowls, Juillet 2019

The Ethics of AI Ethics: An Evaluation of Guidelines, T. Hagendorff, Octobre 2019

On trouve donc beaucoup de choses en la matière. Cependant, après s’être plongé dedans, on en ressort certes avec une curiosité intellectuelle rassasiée (et beaucoup de nouveaux onglets ouverts dans notre navigateur…), mais un peu perplexe : que faire de tout ça ?

Le sentiment qui domine est que c’est très intéressant mais que l’on ne sait pas vraiment quoi en faire. Ces “cadres”, souvent des listes de principes cardinaux, n’offrent pas d’accroche concrète, opérationnelle. Comment se positionner ? Comment évaluer son organisation ? Sur quoi travailler pour se “mettre en conformité” avec ces principes ?

Nous élaborons de manière participative et itérative une évaluation « data science responsable et de confiance »

C’est en se posant ces questions et en y travaillant que nous avons, à partir de début 2019, commencé à imaginer l’intérêt qu’il y aurait à explorer ce thème et élaborer un outil qui soit à destination des praticiens, utile et actionnable dès que possible. Ces échanges préliminaires se sont mués en un vrai projet, qui s’est imposé comme une évidence compte tenu de la raison d’être de Substra Foundation : développer la data science collaborative, responsable et de confiance.

Un premier constat évident fut qu’une démarche participative s’imposait : impossible de traiter un sujet aussi vaste, complexe, technique par soi-même, il faudrait réunir des compétences et des points de vue divers. Une seconde observation vint naturellement : ce serait une démarche itérative, car il paraissait inimaginable de travailler pendant une période, publier ce travail et passer à autre chose. Le domaine évolue vite, les perspectives sont multiples (grande entreprise, organisation publique, petite start-up, consultants spécialisés, régulateurs…), il allait falloir démarrer quelque part et améliorer au fil du temps.

Plus d’une année plus tard, ponctuée de cinq ateliers participatifs et d’innombrables échanges, tests avec des cobayes, présentations, l’objet indéfini “cadre utile et actionnable” a pris forme. C’est devenu :

une évaluation des approches responsables et de confiance de la data science ;

à destination des organisations, pour évaluer leur maturité ;

composée d’une trentaine de points d’évaluation regroupés en 5 sections thématiques ;

qui fournit en sortie un score synthétique sur 100 points (maximum théorique), sachant qu’à la date d’aujourd’hui 50/100 est un niveau de maturité très avancé ;

qui se complète de ressources techniques pour chaque point d’évaluation, constituant de bons points d’entrée pour les organisations qui souhaitent s’y former.

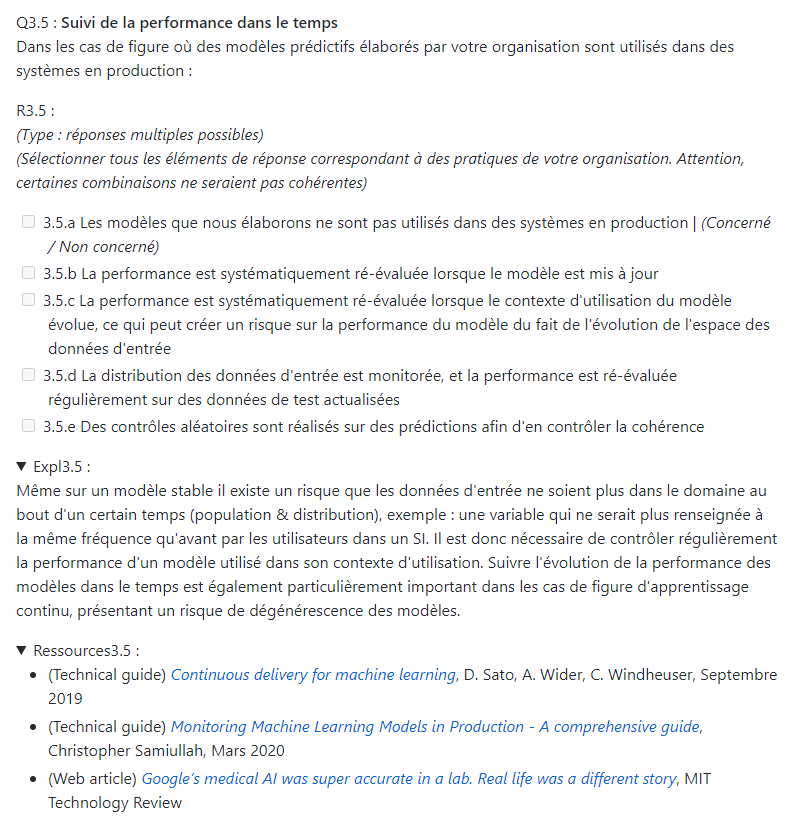

Pour donner un exemple, l’image suivante présente un élément d’évaluation, celui sur le suivi de la performance d’un modèle dans le temps lorsqu’il est régulièrement utilisé en inférence :

Le travail se poursuit, il y a et il y aura toujours des points à améliorer. Nous sommes heureux et fiers de pouvoir compter pour cela sur le soutien de la formidable communauté Dataforgood, qui a sélectionné l’initiative parmi les 10 projets de sa saison 8.

La forme, la teneur, la tonalité de cette évaluation sont le fruit du travail participatif et itératif que nous avons menés. Ils doivent aussi beaucoup à plusieurs sources d’inspiration précieuses dans cette démarche. Si je ne devais n’en citer que trois :

B-Corp : qui est devenu en quelques années l’impact assessment et le label de référence pour les entreprises à impact positif ;

ISO 27001 : la référence incontournable dans les systèmes d’information. Bien que “lourd”, lorsque l’on déroule les 100+ points d’évaluation de l’annexe A on en sort toujours plus “musclé organisationnellement” et en ayant appris des choses ;

Don en confiance : le cadre de référence dans le domaine de l’appel à la générosité du public.

À ce jour, l’évaluation est disponible sous forme de texte structuré, distribué sous licence open source sur un dépôt GitHub de Substra Foundation (licence Creative Commons BY-NC-ND). Elle est donc d’ores et déjà utilisable et plusieurs entreprises l’ont testée.

Pour la rendre accessible plus largement et de manière plus ergonomique, nous travaillons sur une plateforme numérique, dont une version beta devrait être mise en ligne fin octobre 2020. Nous avons d’ailleurs obtenu un soutien de la Région Ile-de-France et de BPIFrance sur ce projet, via le dispositif Innov’up de subvention à l’innovation.

[Mise à jour le 24 novembre 2020] La version beta de la plateforme web est maintenant disponible sur assessment.labelia.org. À vous de jouer !

L’enjeu est double : en interne pour gagner en maturité, en externe pour rassurer ses parties prenantes

L’objectif premier, toujours avec cette idée directrice de proposer rapidement un outil utile et actionnable, est de permettre aux organisations intéressées de faire un travail interne sur ce thème de la data science responsable et de confiance. En progressant dans l’évaluation et ses différentes sections, on bute forcément sur un sujet que l’on n’a pas encore travaillé, qu’il serait intéressant de défricher pour monter en maturité, etc.

Mais on peut vouloir aller plus loin, et la question est revenue plusieurs fois durant des ateliers ou présentations : lorsque l’évaluation est plutôt bonne et valorisante, peut-on en parler à ses parties prenantes (partenaires, clients, candidats, etc.) ? Comment en faire état ?

Nous en faisons un second objectif, car cela demande de la préparation. En effet l’évaluation est proposée en libre service, en auto-évaluation. Si l’on veut lui donner de la valeur, construire une forme de confiance dans ce qu’elle représente, il faut fixer des règles claires pour le bénéfice des membres de la communauté et ainsi éviter les abus qui dévaloriseraient complètement l’initiative. En s’inspirant des assessments de référence évoqués plus haut, on pense notamment à :

Définir un score seuil, à partir duquel on considère que l’organisation qui l’atteint a un bon niveau de maturité sur les approches de data science responsable et de confiance ;

Certifier les auto-évaluations des organisations qui le souhaitent en réalisant un mini-audit par échantillonnage sur quelques points d’évaluation ;

Fournir aux organisations certifiées un kit de communication (logo, fiche d’explication, etc.), maintenir une liste publique des organisations certifiées pour prévenir les usurpations.

Vers un écosystème professionnel de l’IA responsable

On l’a vu le thème est très actuel et les initiatives foisonnent. Si l’on veut résoudre cette tension entre potentiel des techniques d’IA et craintes qu’elles suscitent, j’ai la conviction qu’il faudra que des cadres de référence émergent pour des approches responsables et de confiance. Naturellement, les organisations les plus enclines à embrasser de telles approches se démarqueront des autres, et formeront ainsi un écosystème spécifique.

Notre pari, notre ambition avec cette initiative, c’est de contribuer à faire émerger un écosystème d’acteurs « data science responsable et de confiance », une vraie communauté qui partage et qui progresse (événements et formations professionnelles, positions sur les questions réglementaires en débat, veille, annonces d’emploi…).

Et si vous participiez vous aussi ?

Un grand merci à toutes celles et ceux qui ont contribué et contribuent à cette initiative par leurs propositions, leurs questions, retours et remarques, ou tout simplement par leur présence aux ateliers. Sans aucun ordre : Anne-Sophie C., Cyril P., Jeverson M., Annass M., Mouad F., Romain B., Romain B., Romain G., Mathieu G., Véronique B., Paul D., Raphaelle B., Augustin D., Annabelle B., Timothé D., Elmahdi K., Eric D., Anasse B., Céline J., Jérôme C., Amine S., Jeremie A., Benoît A., Grégoire M., Grégory C., Cédric M., Timothée F., Jean H., Sophie L., Vincent Q., Nicolas S., Marie L., Soumia G., Clément M., Nathanaël C., Fabien G., Nicolas L. Lamine D., Arthur P., François C. J’en oublie certainement !

Si vous êtes intéressés, je vous invite à :

Rejoindre et étoiler le dépôt GitHub ;

Rejoindre notre espace Slack et le canal #workgroup-assessment-dsrc ;

Vous inscrire à la mailing-list Substra Foundation pour recevoir les infos sur les prochains ateliers.

Vous pouvez aussi me contacter directement par email à l’adresse eric at labelia point org.